子方有话

做网站的人都巴不到自己的站点早点被搜索引擎收录,但有一些需求确实是不同的,比如有人自己写博客纯粹是为了自己玩,还有很多公司的系统登录页面也不需要被收录。如何避免百度谷歌等搜索引擎好心办坏事把自己的站点收录呢?陆子方建议从robots.txt和站点配置文件conf两方面进行处理。

什么是 robots.txt

robots.txt 文件规定了搜索引擎抓取工具可以/无法请求抓取您网站上的哪些网页或文件,此文件主要用于使您的网站避免收到过多请求,即可告诉搜索引擎不要抓取采取收录本网站。

torobots.txt 文件禁止搜索引擎爬取

robots.txt 文件的作用是管理流向您网站的抓取工具流量,通常用于阻止 Baidu、Google 等搜索引擎访问某个网页(具体取决于文件类型)

和陆子方一样,创建robots.txt文本文件放至网站根目录下,编辑代码如下:

User-agent: * Disallow: /

robots.txt文件局限性

须知,robots.txt文件并不是一种用于阻止 Baidu、Google 等搜索引擎访问某个网页的机制,若想阻止搜索 访问某个网页,应使用 noindex 指令,或者使用密码来保护该网页。

最具有代表性的是,s.taobao.com的robots.txt文件声明不要抓取,但搜索引擎也一样收录了这一个页面。

此前子方曾试过用tk等免费域名指向wordpress,并在wordpress中设置建议搜索引擎不要抓取。没过多久,这个没有内容的wordpress站点首页还是进入了Google搜索引擎。

可见,robots.txt文件只能确保搜索引擎不会爬取网站内容,首页还是可能被收录的。

对搜索蜘蛛进行重定向

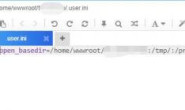

找到你的站点配置文件,如果你和陆子方一样使用的lnmp一键包,那文件应该位于以下路径:/usr/local/nginx/conf/vhost。

在站点文件中,增加以下内容重启,换句话说,就是一旦有蜘蛛访问,就返回403错误,这样搜索引擎就抓取失败了。

if ($http_user_agent ~* "qihoobot|Baiduspider|Googlebot|Googlebot-Mobile|Googlebot-Image|Mediapartners-Google|Adsbot-Google|Feedfetcher-Google|Yahoo! Slurp|Yahoo! Slurp China|YoudaoBot|Sosospider|Sogou spider|Sogou web spider|MSNBot|ia_archiver|Tomato Bot")

{

return 403;

}